AI in der Praxis: Das haben wir bisher gelernt

Seit ChatGPT geht es im Bereich AI Schlag auf Schlag. Auch wir haben AI in unser Toolkit aufgenommen, um uns selbst sowie unseren Kund*innen in ganz unterschiedlichen Situationen weiterzuhelfen. Was haben wir dabei gelernt?

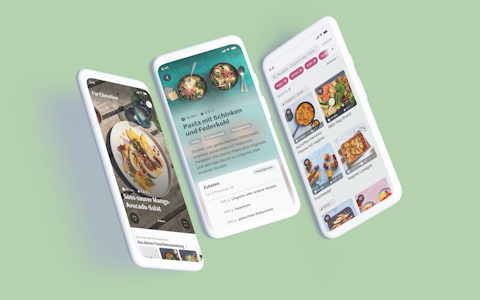

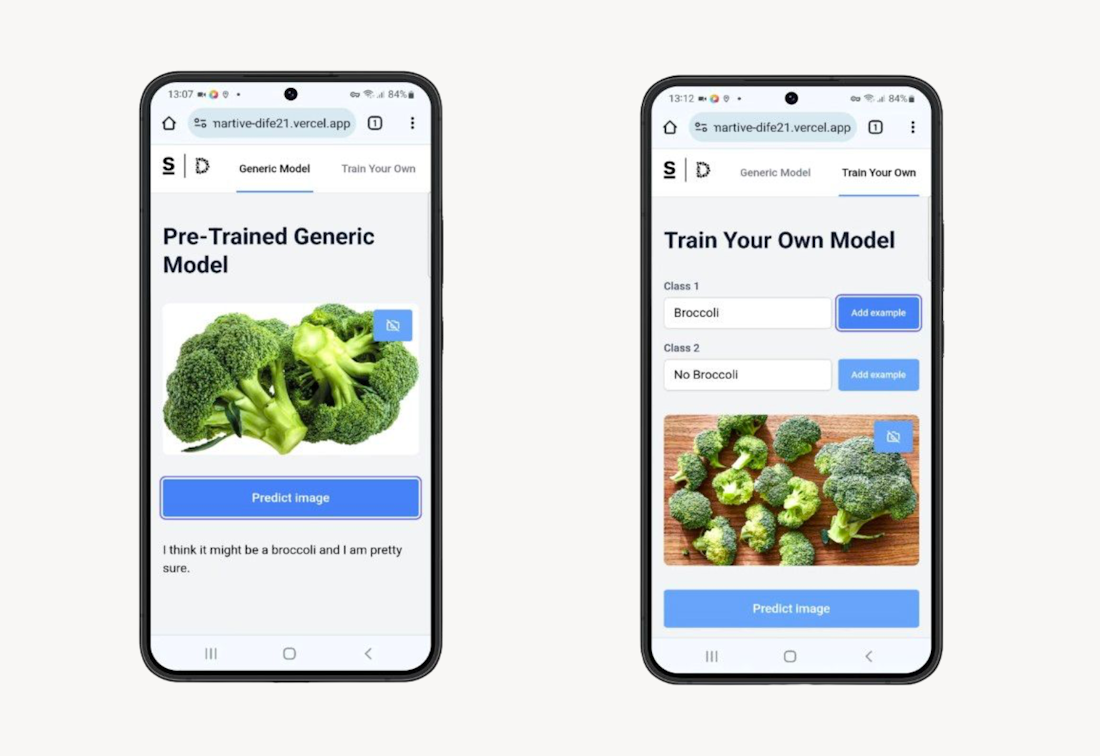

Wir schreiben das Jahr 2021. Auf dem Digital Festival stellen wir eine einfache Bilderkennungs-App vor die mit einem grundlegenden Machine Learning-Modell arbeitet. Eine nette Spielerei, die zeigt, wie man mit ein paar Tricks einer App das Erkennen von Alltagsobjekten beibringen kann. Der Wow-Effekt ist da, aber klar wird auch: Wir stehen erst am Anfang.

Ende 2022 kommt dann der richtige Durchbruch: ChatGPT. Plötzlich ist AI in aller Munde. Das möglich gemacht haben Transformer-Modelle – der kleine magische Helfer im Hintergrund. Transformer erlauben es, parallele Berechnungen zu machen und komplexe Zusammenhänge im Text zu verstehen. Das Ergebnis? Ein AI-Modell, das nicht nur zuhört, sondern auch intelligent antwortet. Beeindruckend, oder?

Seither geht es im Bereich AI Schlag auf Schlag, und auch wir haben AI in unser Toolkit aufgenommen, um uns selbst sowie unseren Kund*innen in ganz unterschiedlichen Situationen weiterzuhelfen. Was haben wir dabei gelernt?

Trainier eigene Modelle nur, wenn es sich wirklich lohnt

Ein eigenes AI-Modell zu trainieren, sogenanntes Finetuning, ist ziemlich aufwendig. Ressourcen, Daten, Rechenpower – alles muss passen, sonst wird es teuer und ineffizient. In der Anfangsphase lohnt es sich oft viel mehr, eine gute Suche über die eigenen Daten zu entwickeln.

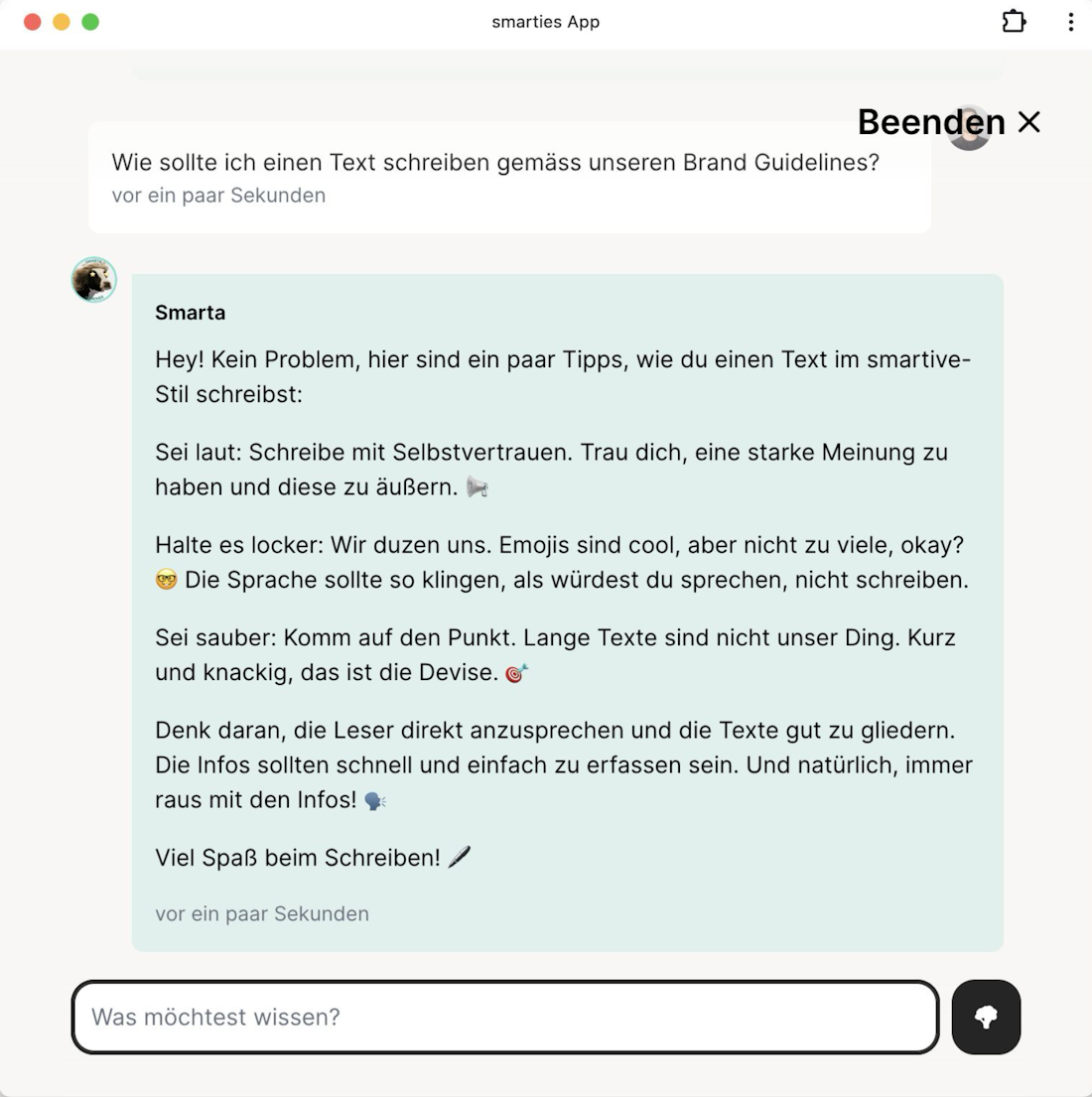

Unsere Erfahrung mit dem internen Chatbot "Smarta" hat genau das gezeigt. Smarta nutzt Retrieval-Augmented Generation (RAG), um die passenden Infos zu finden. Statt ein eigenes Modell zu trainieren, sucht Smarta über bestehende Dokumente und liefert punktgenaue Antworten. Das spart Zeit und Nerven. Als Bonus profitieren wir auch immer direkt von neuen, stärkeren AI-Modellen, sobald diese verfügbar sind.

Die grossen AI-Modelle wissen (fast) alles – und das ist ein Problem

AI-Modelle wie GPT-4 oder Llama 3 sind so trainiert, dass sie möglichst viel Wissen aus vielen Quellen integrieren. Das klingt gut, aber was passiert, wenn die AI auch dann antwortet, wenn sie eigentlich nichts Genaues weiss oder wissen darf? Genau hier liegt die Herausforderung.

Wir haben gelernt, dass klares Prompting sehr wichtig ist, um den Aufgabenbereich und Leitplanken für die AI zu definieren. Ebenfalls sollten Benutzereingaben eingeschränkt werden, um zu verhindern, dass der Beratungsbot im Online-Shop plötzlich Mathehausaufgaben löst. In kritischen Fällen kann auch eine zweite AI eingesetzt werden, um das Ergebnis der ersten AI auf wichtige Kriterien zu überprüfen. So wird sichergestellt, dass die Antworten nicht nur korrekt, sondern auch relevant und nachvollziehbar sind.

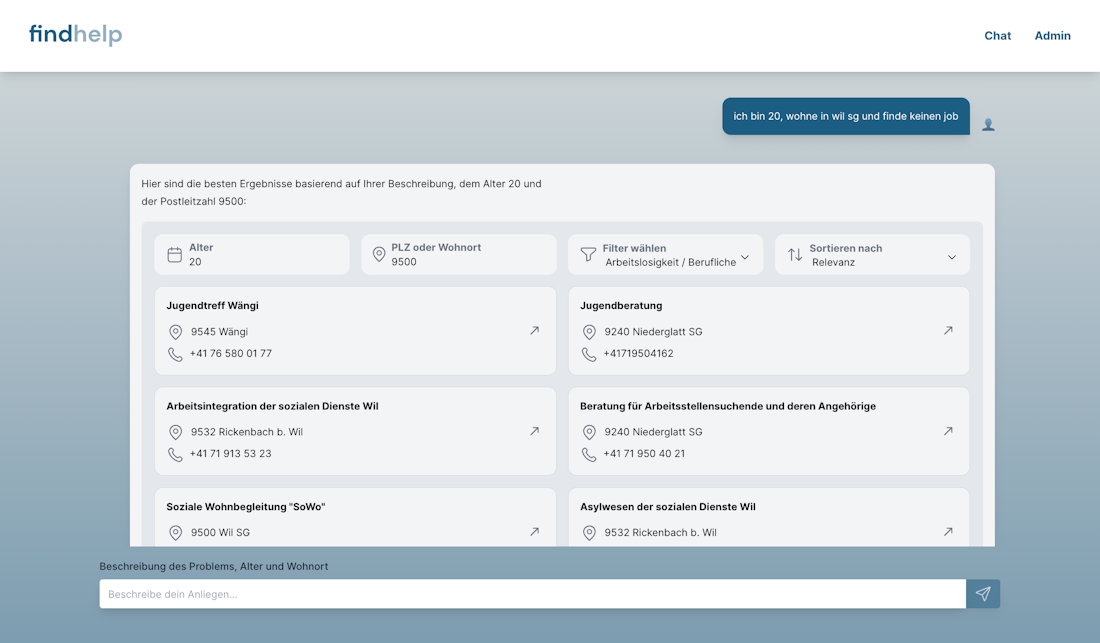

Textbasierte Chatbots bieten oft eine miese User Experience

Kennst du das: Du klickst dich durch eine endlose Konversation mit einem Chatbot und am Ende kriegst du trotzdem keine brauchbare Antwort? Oder du siehst dieses leere Textfeld vor dir und hast keine Ahnung, wo du anfangen sollst? Genau das wollen wir verhindern. Mit generativen UIs können wir eine viel bessere Erfahrung bieten. Dabei nutzen wir AI nicht, um textbasierte Antworten zu generieren, sondern traditionelle, aber relevante UIs.

Ein gutes Beispiel ist unser "findhelp"-Chatbot, der Menschen in schwierigen Situationen hilft. Statt langer Textantworten liefert er eine klare Liste von Angeboten, die direkt weiter gefiltert werden kann. Das spart Frust und bringt Nutzer*innen schneller ans Ziel.

Das Problem kommt vor der Lösung

AI sollte nicht das Allheilmittel sein, das man über jedes Problem stülpt oder in jede Applikation einbaut. Zuerst muss ein Problem identifiziert und verstanden werden.

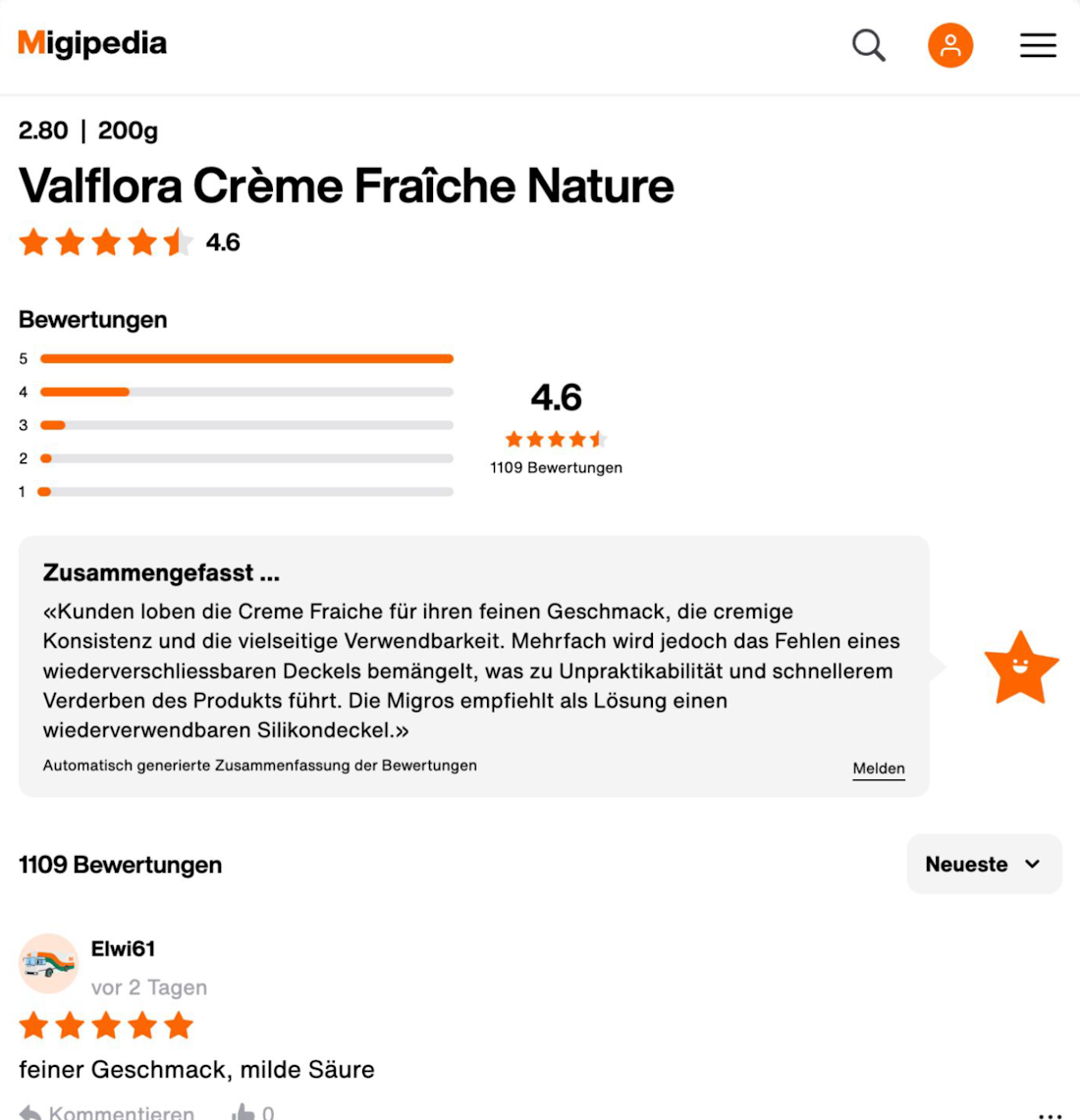

Bei Migipedia hatten wir das Problem, dass die Menge an Produktbewertungen kaum noch sinnvoll erfassbar war. Wir testeten verschiedene Lösungen wie Filter und Sortierungen – ohne grossen Erfolg. Erst durch den Einsatz von AI konnten wir eine gute Zusammenfassung der Bewertungen entwickeln, die den Nutzer*innen die wesentlichen Infos liefert, ohne sie zu überfordern. Eine gute AI-Lösung startet mit einem klaren Problem.

AI brilliert bei grossen, unstrukturierten Datenmengen

Einer der grössten Vorteile von AI ist der Umgang mit unstrukturierten Daten. Texte, Audio, Videos – all das kann durch AI zugänglicher gemacht werden. Ein Beispiel sind unsere internen "Smart Talks" für Mitarbeitende, bei denen die Vorträge automatisch zusammengefasst werden. Aus einer Audio-Aufnahme entsteht so voll automatisiert ein kurzer Blogpost, den alle leicht nachlesen können. Das spart Zeit und stellt sicher, dass Wissen weitergegeben wird, ohne dass jemand mühsam Notizen schreiben muss.

Fazit

AI ist ein Werkzeug, das viele Möglichkeiten bietet. Doch wie bei jedem Werkzeug gilt: Es muss richtig eingesetzt werden. Unsere Erfahrungen zeigen, dass es oft darum geht, pragmatische Lösungen zu finden – sei es durch kluge Suche, klare User Experience oder einfach die Vermeidung von überflüssigem Aufwand.

Fang beim Problem an, das du lösen willst, und prüf dann, ob AI wirklich der beste Ansatz ist. Denn am Ende des Tages geht es darum, echten Mehrwert zu schaffen.

Geschrieben von

Mirco Strässle